11 декабря 2025, 14:34

5 минут

Python-парсинг: что это, как работает и при чем здесь деньги

Представьте, что вам нужно собрать цены на 10 000 товаров с Ozon или вытащить все новости с сайта-конкурента за год. Вручную — это месяцы работы. Специальными сервисами — дорого и негибко. А теперь представьте, что вы можете написать программу, которая сделает это за вас за пару часов. Это и есть парсинг сайтов на Python — самый мощный и гибкий способ автоматизировать сбор данных из интернета. Если вы хоть раз гуглили «питон парсинг сайта» или «обучение парсингу сайтов», то вы на правильном пути. Давайте разберемся, как это работает, с чего начать и когда стоит поручить это профессионалам.

Что такое парсинг сайтов на Python простыми словами?

Если не углубляться в технические дебри, парсинг данных с сайта Python — это процесс, когда специальная программа (скрипт) автоматически заходит на веб-страницы, находит нужную информацию (цены, тексты, контакты) и аккуратно складывает ее в таблицу или базу данных. Представьте очень дотошного и быстрого клерка, который может обработать тысячи страниц без устали и ошибок.

Парсинг с использованием Python особенно популярен, потому что Python — это как швейцарский нож для программиста: он понятный для начинающих (парсинг сайтов на python для начинающих — одна из самых частых тем) и невероятно мощный в руках эксперта. А главное — для него есть готовые инструменты, которые мы рассмотрим ниже.

Зачем это нужно? Не гиковская прихоть, а бизнес-необходимость

- Собранные данные — это нефть цифрового мира. Python парсинг данных используют не только программисты, но и маркетологи, аналитики, предприниматели. Вот лишь несколько реальных примеров:

- Анализ рынка и конкурентов.

- Автоматический парсинг сайтов с помощью python позволяет отслеживать цены, ассортимент и акции ваших конкурентов на Wildberries, Ozon или в любом интернет-магазине.

- Создание собственных агрегаторов.

- Собирать товары, вакансии или недвижимость с разных площадок в одну базу.

- Наполнение сайтов контентом.

- Легальный сбор публичных данных (новостей, описаний продуктов) для дальнейшей обработки и публикации.

- Для личных целей.

- Отслеживание падения цены на авиабилеты или сбор email-адресов с сайтов в вашей нише для рассылки.

- Проще говоря, если в интернете есть публичные данные, которые вам нужно получить системно, парсинг сайтов простой (на первый взгляд) скрипт на Python решит эту задачу.

С чего начать? Главные инструменты для парсинга на Python

Сердце любого парсера — это библиотеки. Библиотека парсинг сайта — это готовый набор функций, который избавляет вас от написания тонн сложного кода. Вот две ключевые связки:

1.BeautifulSoup + Requests: классика для начинающих

- Requests: Эта библиотека отвечает за «разговор» с сайтом. Она отправляет запросы (как ваш браузер) и получает HTML-код страницы.

- BeautifulSoup: А вот это и есть волшебная палочка. Beautifulsoup парсинг сайта — это когда эта библиотека берет неудобоваримый HTML-код, который получает Requests, и позволяет вам легко «вытаскивать» из него нужные данные: заголовки, цены, ссылки. Это основа парсинга сайтов на python beautifulsoup.

2.Scrapy: тяжелая артиллерия для проектов

Если вам нужно собрать данные со всего сайта (десятки тысяч страниц), то создание парсинга сайтов на фреймворке Scrapy будет эффективнее. Это уже не просто библиотека для парсинга сайтов python, а целый каркас для построения сложных, быстрых и надежных пауков (spiders), которые обходят сайты по ссылкам.

3.Selenium: для «живых» сайтов

Некоторые сайты подгружают контент с помощью JavaScript. BeautifulSoup его не видит. Тут на помощь приходит Selenium — он умеет управлять реальным браузером, дожидаться загрузки и затем парсить готовую страницу.

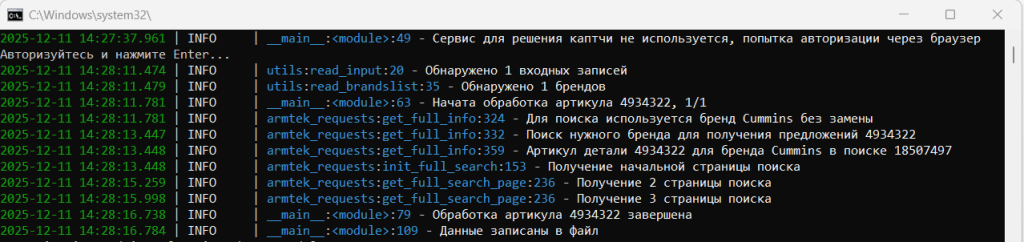

Кстати, мы разрабатываем парсеры на заказ. Например:

Как выглядит простейший код парсинга сайта на Python?

Давайте заглянем «под капот». Вот как может выглядеть парсинг сайта на python код для получения всех заголовков с новостной ленты (условный пример):

import requests

from bs4 import BeautifulSoup

# 1. Отправляем запрос к сайту (как если бы зашли в браузер)

url = ‘https://example-news-site.ru’

response = requests.get(url)

# 2. Передаем полученный HTML в BeautifulSoup для разбора

soup = BeautifulSoup(response.text, ‘html.parser’)

# 3. Ищем все заголовки (предположим, они в тегах <h2 class=”title”>)

news_titles = soup.find_all(‘h2’, class_=‘title’)

# 4. Выводим результат

for title in news_titles:

print(title.text)

Это и есть основа. Дальше вы учитесь работать с циклами, сохранять данные в CSV и обходить базовую защиту.

А если сайт сложный? Проблемы и пути их решения

Парсинг сайтов простой — это про статичные сайты-визитки. В реальности вы столкнетесь с препятствиями, и здесь начинается профессиональный парсинг с использованием python.

Стоит ли учиться самому или заказать парсинг?

Это ключевой вопрос. Давайте разделим аудиторию:

- Вам стоит попробовать самим, если: Вы технарь по духу, хотите разобраться для личных целей или у вас есть время на обучение парсингу сайтов. Это отличный навык!

- Вам стоит заказать разработку парсера, если:

- Время = деньги. Вам нужно решение «вчера», а не через месяц обучения.

- Масштаб. Нужно собрать миллионы записей с десятков ресурсов.

- Сложность. Целевые сайты имеют сильную защиту (Cloudflare, сложный JS).

- Надежность. Вам нужна не разовая выгрузка, а стабильная работающая система, которая будет поставлять данные годами.

- Интеграция. Собранные данные должны автоматически попадать в вашу CRM, Google Sheets или на сайт.

Парсинг данных питон — это инструмент. Иногда дешевле и эффективнее купить готовый качественный инструмент, чем месяцами учиться его ковать.

Заключение: Python — ваш ключ к миру данных

Парсинг сайтов на Python открывает двери в мир автоматизации и data-driven решений. Начиная с beautifulsoup парсинг сайта, вы можете вырасти до создания сложных распределенных систем сбора данных. Это навык, который окупается многократно, экономя сотни часов ручной работы.

Но если вам нужно не знание процесса, а конкретный результат — стабильный поток структурированных данных для вашего бизнеса — то оптимальным решением будет поручить создание парсинга сайтов опытной команде. Мы разрабатываем надежные парсеры на Python, которые работают с любыми сайтами, обходят блокировки и становятся частью вашей бизнес-инфраструктуры.

P.S. Мой первый парсер на BeautifulSoup собирал курс доллара с сайта банка, и я так гордился этим, что показывал скрипт всем знакомым — сейчас, глядя на него, я просто улыбаюсь той наивной простоте.