29 декабря 2025, 16:47

5 минут

Парсинг данных с сайта в Excel: работа должна быть комфортной

Устали от бесконечного копирования цен, описаний или контактов вручную? Знакомо чувство, когда на сбор информации с десяти сайтов уходит целый рабочий день, а в таблице царит хаос? Вы не одиноки. Парсинг данных с сайта в Excel — это не магия, а рабочий процесс, который освобождает время для анализа, а не для монотонного труда. В этой статье я простым языком объясню, как превратить любой сайт в структурированную таблицу автоматически, какие инструменты работают, а какие подводят, и почему иногда лучше заказать собственное решение.

Что такое парсинг сайта в Excel и почему это нужно каждому бизнесу?

Если коротко, парсинг (или сбор данных) — это автоматическое извлечение информации с веб-страниц и её сохранение в удобном формате. А Excel здесь — самый понятный и востребованный конечный пункт. Практически любой отчёт, анализ или база данных начинаются с этой таблицы.

Парсинг сайтов в Excel решает конкретные боли:

- Ценообразование. Автоматически отслеживайте цены конкурентов на сотни позиций.

- Формирование каталогов. Соберите описания, характеристики и артикулы для вашего интернет-магазина.

- Анализ рынка. Получите данные о вакансиях, отзывах, товарах или услугах в вашей нише.

- Поиск клиентов. Соберите базу контактов с сайтов компаний определённой отрасли.

Представьте: вместо восьми часов рутинного копирования вы получаете готовый файл за пять минут запуска скрипта. Парсинг данных эксель — это ваш личный цифровой помощник для сбора информации.

Как сделать парсинг Excel? 3 реальных способа

Выбор метода зависит от ваших задач, бюджета и технических навыков. Давайте разберём все варианты.

H3: 1. Вручную или «Копировать-Вставить»: способ для разовой задачи

Подходит, если нужно собрать данные с 1-2 страниц.

- Как работает: Вы выделяете текст на сайте, копируете и вставляете в ячейку Excel.

- Плюс: Не требует никаких вложений и обучения.

- Минус: Неэффективно, много ошибок, абсолютно не масштабируется. Это не парсинг сайта, это труд каменного века цифровой эпохи.

H3: 2. Готовые парсеры и расширения для браузера

Идеальный старт для многих пользователей. В интернете действительно есть программы для парсинга, которые работают по принципу «укажи — получи».

- Как работает: Вы устанавливаете расширение в Chrome, выделяете нужные данные на странице (например, названия товаров в списке), и программа преобразует их в таблицу.

- Плюсы: Относительно быстро, не нужно программировать, часто есть бесплатный тариф.

- Минусы: Хрупкие настройки (ломаются при малейшем изменении дизайна сайта), ограничения по количеству страниц, слабая гибкость.

H3: 3. Индивидуальный парсер (кастомная разработка)

Решение для бизнеса, где данные — это кровь процессов.

- Как работает: Разработчики пишут уникальную программу под вашу задачу. Она заходит на сайт, находит нужные данные по чётким правилам и выгружает их в Excel — хоть каждый час, хоть с тысячи страниц.

- Плюсы: Максимальная точность, работает с любыми сайтами (даже с динамической подгрузкой), полная автоматизация, интеграция с вашими системами.

- Минус: Требует начальных инвестиций.

Простой выбор: Если вам нужно один раз спарсить прайс-лист — хватит расширения. Если парсинг данных с сайта в Excel — это ежедневная задача для отдела маркетинга или аналитики, пора задуматься о собственном решении.

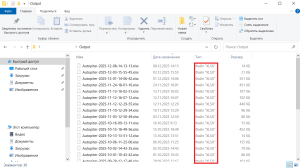

Кстати, мы разрабатываем парсеры на заказ. Например:

Что можно выгрузить в таблицу? Объекты для парсинга

Возможности современного парсинга сайтов почти безграничны. Вот что чаще всего оказывается в колонках Excel:

- Товарные данные: Название, цена, артикул, наличие, категория, рейтинг, отзывы.

- Текстовый контент: Статьи, новости, описания, комментарии.

- Структурированные данные: Контакты (телефоны, email), адреса, графики работы, список сотрудников.

- Медиа-информация: Ссылки на изображения или видео.

Фактически, всё, что вы видите на странице, можно аккуратно разложить по столбцам A, B, C и так далее.

Как выглядит процесс разработки парсера под ваши задачи?

Если вы задумались о собственном решении, вот из каких этапов состоит работа:

- Обсуждение цели. Что за сайты? Какие именно данные нужны (название столбцов в Excel)? Как часто собирать?

- Анализ и прототип. Разработчики изучают структуру сайта, пишут тестовый скрипт и показывают вам образец выгрузки.

- Создание программы. Написание основного кода, который будет стабильно собирать данные.

- Тестирование и доработка. Проверка на разных страницах, в разное время, учёт возможных ошибок.

- Запуск и поддержка. Внедрение решения у вас. Мы всегда на связи, если сайт-источник кардинально изменится и парсер потребует адаптации.

В итоге вы получаете не просто программу для парсинга данных Эксель, а отлаженный инструмент, который становится частью вашего бизнес-процесса.

Хватит тратить жизнь на копирование — доверьте это машине

Время — самый ценный ресурс. Его стоит инвестировать в анализ полученных данных, стратегию и развитие, а не в механическую работу. Парсинг данных с сайта в Excel — это первый шаг к цифровой трансформации даже небольшого отдела.

Мы разрабатываем умные парсеры, которые работают пока вы спите, и готовы обсудить вашу задачу. Опишите, какую информацию и с каких источников вы хотите получать в виде чёткой таблицы — мы предложим оптимальное решение, которое окупится за счёт сэкономленных человеко-часов уже в первый месяц.

P.S. Знаете, когда я впервые настроил автоматический сбор цен для своего знакомого, он просто вышел и выпил кофе, пока программа делала его трёхдневную работу — вот с этого момента и начинается настоящая эффективность.